Un serio problema

Hace unos días, un tesista me envió un correo electrónico diciéndome que me remitía ahí mismo el borrador completo de su tesis para hacer la última lectura de revisión antes de someterla al comité académico. Verdaderamente entusiasmado -porque es un trabajo excelente y que lo va a llevar pronto a obtener su grado- abrí el correo, pero mi sorpresa fue mayúscula ya que no encontré ningún archivo adjunto. En cuanto me percaté que el email no tenía un attachment, me comuniqué con el tesista para decirle que su texto no se había adjuntado al correo. Unas (muchas) horas después recibí otro correo en el que me explicaba que había tenido innumerables problemas para adjuntar el archivo al envío y que optaba por hacérmelo llegar por Dropbox. El archivo, que está escrito de origen y guardado como un documento .docx de MS Word ocupa casi 18MB de unidades de información. Sin embargo, su extensión no rebasa las 310 cuartillas y sólo contiene algunas cuantas ilustraciones y mapas. Nada del otro mundo, en cuanto a extensión, que amerite los 18MB (¡18’000,000 de bytes!) de espacio en mi disco duro, cuando bien podría tener solamente 1MB, considerando que cuenta apenas con cerca de 780 mil caracteres más las imágenes, que son pocas, si se ponen en baja resolución. Para tener una idea de qué es a lo que me refiero en términos de extensión, cada carácter equivale aproximadamente a 1 byte por lo que 10MB de unidades de información equivalen a dos veces la obra completa de Shakespeare.

El problema no es solamente la extensión o «peso» del archivo, sino la posibilidad de manipularlo. Como todo borrador de un trabajo, aún debe ser corregido y anotado con las observaciones del director. Si bien MS Word cuenta con una herramienta para ello (-> Herramientas -> Control de cambios), su uso es realmente engorroso y no permite una apreciación cabal y por separado de las correcciones y de las anotaciones. Por otro lado, cualquier cosa que se modifique en el texto, aún siendo solamente el añadido de una coma u otro signo de puntuación, hace tambalear todo el formato del documento, muy probablemente porque el mismo fue generado en una plataforma distinta a la que utilizamos para su corrección (el paso de Windows a Mac, por ejemplo). Incluso, después de trabajar una nota sobre un cambio sustancial, el programa se colapsa y se cierra, descartando los cambios. De esta manera, ponerse a corregir y anotar con la atención debida un trabajo tan interesante, es imposible pues acaba uno por desesperarse y restarle atención al contenido (que es lo importante) por estar preocupado del funcionamiento del procesador de textos. Más valdría entonces imprimirlo en papel para corregirlo y anotarlo de la manera tradicional, lo cual es un contrasentido tratándose de un documento digital, por no hablar del peso que sobre mi conciencia ecológica significaría gastar papel en un borrador.

En los años que tengo de trabajar en entornos digitales (por lo menos 35), ningún procesador de textos me ha dado tantos problemas como el MS Word, en cualquiera de sus versiones. En tiempos de los sistemas operativos DOS, tanto en MS como en Apple, los procesadores como WordStar, WordPerfect o Apple Writer ofrecían un buen servicio: eran robustos, sencillos y eficaces. Raramente se colapsaban, generaban archivos ligeros, y uno podia concentrarse en la tarea fundamental: escribir. Y es que aquellos procesadores carecían de las características actuales, estructuradas con la filosofía del WYSIWYG,1 y uno podía dedicarse a escribir vertiendo fluidamente las ideas en el texto sin distraerse con los detalles del diseño de los márgenes, el formato de los títulos y subtítulos de cada capítulo, el acomodo de las notas a pie y de las referencias bibliográficas así como los demás agregados, gráficos o textuales. Uno escribía y, después del punto final, se dedicaba a acomodar las cosas.

Los procesadores de texto, particularmente el MS Word, no están diseñados para la escritura académica o la literaria. Esto lo han discutido ya varios escritores, científicos sociales y humanistas. Charles Stross, un conocido escritor de ciencia ficción radicado en Escocia, fue al extremo de argumentar Why Microsoft World must Die -«Por qué debe morir MS Word»:

Microsoft Word es un tirano de la imaginación, un pequeño dictador carente de

imaginación e inconsistente, que es inadecuado para cualquier uso en la escritura creativa.

Peor aún, es casi un monopolio que domina el campo de los procesadores de texto.

Soluciones

La entrada del blog de Stross es muy interesante ya que expone varias razones por las cuales MS Word es inútil para la escritura de textos largos, como las novelas, los libros o las tesis académicas. Más aún, uno de los más graves problemas de éste y otros procesadores de texto, es que resulta imposibile producir un documento digital fiable y con garantía de permanencia dado que las actualizaciones de los programas vuelven obsoletos los archivos con la rapidez inusitada de seis meses en promedio. Todos nos hemos dado cuenta en alguna ocasión que es prácticamente imposible abrir un archivo .docx creado y guardado en la versión más actualizada, con una versión anterior del programa. MS World es un buen recurso para el flujo de trabajo de las oficinas y empresas que generan una ingente cantidad de memoranda, circulares, oficios y cartas con una vida efímera; pero no funciona cuando se trata de generar textos cuyos originales necesariamente deben estar a la mano, funcionales y legibles muchos años después, como los textos académicos. Como una alternativa para contrarrestar los diversos problemas de los procesadores de texto como MS Word, Stross sugiere el uso de Scrivener, un procesador de texto pensado para la escritura de archivos largos. Pero, sobre todo, la mejor alternativa es escribir todo en texto plano, generando y guardando archivos .txt, mucho más flexibles, almacenables, distribuibles, independientes de plataforma2 y con garantía de permanencia y legibilidad a largo plazo. Y para ello no necesitamos un procesador de texto sino simplemente un humilde editor de textos como los que vienen por defecto en todas las máquinas: Notepad++ en Windows, TextEdit en OS-X, o la gran variedad de editores que hay para Linux como Vim o gEdit.

El punto de vista de un novelista como Stross es compartido por muchos académicos, pues los problemas que representan los procesadores de texto no son una novedad entre el gremio. W. Caleb McDaniel, un joven historiador de la Rice University en Houston, TX, y egresado de la prestigiosa Johns Hopkins University, es un verdadero entusiasta de este tipo de escritura sostenible independiente de plataforma y con garantía de permanencia. Basta con leer alguno de sus varios textos dedicados al tema, como por ejemplo, Why (and How) I Wrote My Academic Book in Plain Text -«Por qué (y cómo) escribí mi libro académico en texto plano.» En este texto, McDaniel explica detalladamente el cómo es posible adaptar la escritura en texto plano a los requerimientos de los textos académicos mediante la aplicación de un marcaje semántico en el propio texto con el lenguaje de marcado Markdown, desarrollado por John Gruber y Aaron Swartz. Así, es posible hacer uso de cursivas, negritas, listados, referencias y listas bibliográficas, tablas, notas a pie de página y demas florituras de los modos de escribir en nuestro oficio, con sólo un editor de texto plano. ¡Exacto! Hace falta solamente un editor de texto plano, conocer la sintaxis de Markdown y recurrir a herramientas pensadas especialmente para la escritura académica como Pandoc,3 un traductor que funciona en línea de comandos y que convierte archivos .txt o .md a cualquier formato imaginable: .doc, .docx, .odt, .pdf, .html, .tex y un amplio etcétera. Cabe decir que Pandoc fue desarrollado por John MacFarlane, un profesor de filosofía de la University of California, Berkeley; es decir, se trata de una herramienta para académicos pensada y hecha por académicos. En otras palabras: humanidades digitales en su máxima expresión. Al final de su entrada, McDaniel termina explicando el porqué no volvería a utilizar MS Word en su vida. Y yo estoy de acuerdo con él.

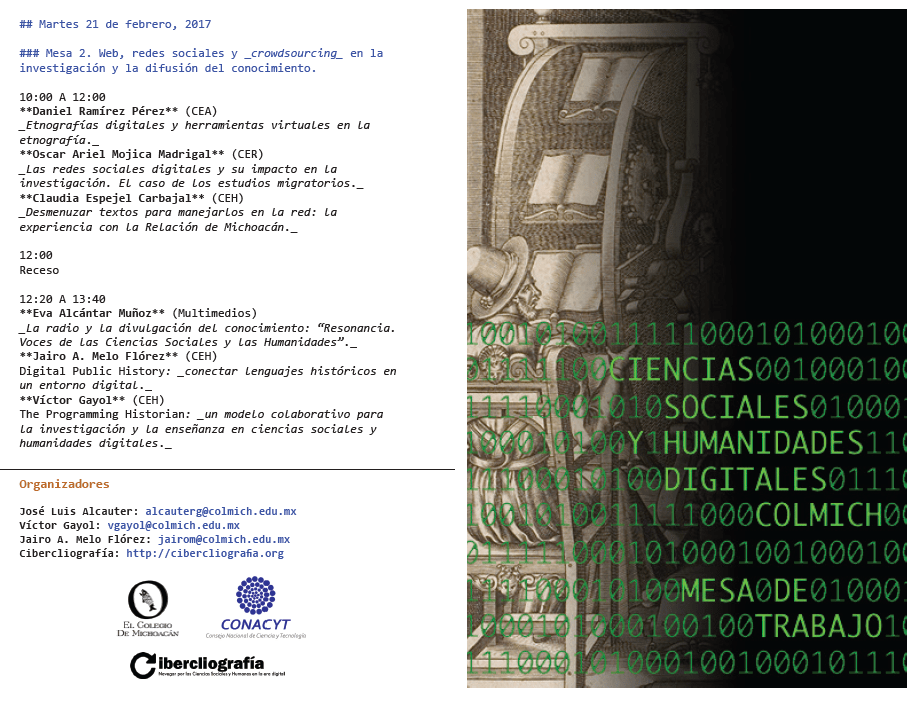

Desde que hace casi un año me topé con el sitio The Programming Historian (de cuyo equipo editorial ahora formo parte),4 descubrí varias herramientas y lecciones que me permitieron dejar de complicarme la existencia con los procesadores de texto, así como otra serie de prácticas sostenibles para la producción académica, al grado de que tengo ya varios meses en los que no he abierto MS Word para escribir mis textos, sino única y exclusivamente para leer los que recibo. A continuación dejo algunas pistas de lo que nos puede ser útil como científicos sociales o humanistas para crear textos académicos digitales sostenibles.

En The Programming Historian se encuentra una buena introducción a Markdown, escrita por Sarah Simpkin, «Getting Started with Markdown.» También hay una excelente lección que nos enseña a generar una escritura sostenible con texto plano, Markdown y Pandoc, escrita por Dennis Tennen y Grant Wythoff, «Sustainable Authorship in Plain Text using Pandoc and Markdown.» Si a esto le sumamos buenas prácticas para la conservación de los datos de nuestra investigación, como las que sugiere James Baker en «Preserving Your Research Data«, podemos tener la seguridad de que nos ahorraremos los incontables dolores de cabeza, pérdidas y problemas que nos depara (casi) siempre el uso de software propietario, lo cual redundará en la calidad, permanencia, posibilidad de distribución y colaboración, almacenamiento y más de nuestros textos académicos.

Para leer más

- Dougherty, Jack y Kristen Nawrotzki. 2013. Writing History in the Digital Age. Ann Arbor: University of Michigan Press. http://writinghistory.trincoll.edu

- Rosenzweig, Roy. 2011. Clio Wired: The Future of the Past in the Digital Age. New York: Columbia University Press. http://public.eblib.com/choice/publicfullrecord.aspx?p=895110.

- Voutssas Márquez, Juan. 2013. Cómo preservar mi patrimonio digital personal. México: Universidad Nacional Autónoma de México, Instituto de Investigaciones Bibliotecnológicas y de la Información.

- Acrónimo de «what you see is what you get» (lo que ves es lo que obtienes), para referirse a la capacidad de la interfaz gráfica de usuario de las aplicaciones para desplegar el diseño de un documento digital tal y como se verá impreso. Sin embargo, la idea de WYSIWYG es tramposa, pues lo que en realidad conseguimos es un archivo con un código y un marcado muy complejos y confusos para nuestro entendimiento, que se aloja en una capa «invisible», lo cual lo hace inmanejable. ↩

- Es decir, legibles sin pérdidas o alteraciones en cualquier plataforma o sistema operativo como Mac, Linux o Windows. ↩

- Pandoc es una «biblioteca» o conjunto de módulos o programas escritos en Haskell, un lenguaje de programación de alto nivel multi propósito, y cuenta con una herramienta de línea de comandos que permite utilizar dicha biblioteca. ↩

- Estamos trabajando muy duro y en breve contaremos con una versión en español de todo el contenido alojado en The Programming Historian. ↩