Hoy por la mañana me tocó exponer una idea para un proyecto de historia digital en el que se podría analizar la cultura jurisdiccional de la monarquía hispánica. Como seguramente no tendrá mayor difusión que la presentación verbal en el contexto del DH2018, dejo aquí el amplio resumen por si alguien tiene interés en intercambiar ideas.

Corpus Jurídico Hispano Indiano Digital: Análisis de una Cultura Jurisdiccional

DH2018 – SP08 – Text Analysis, Cultural Studies

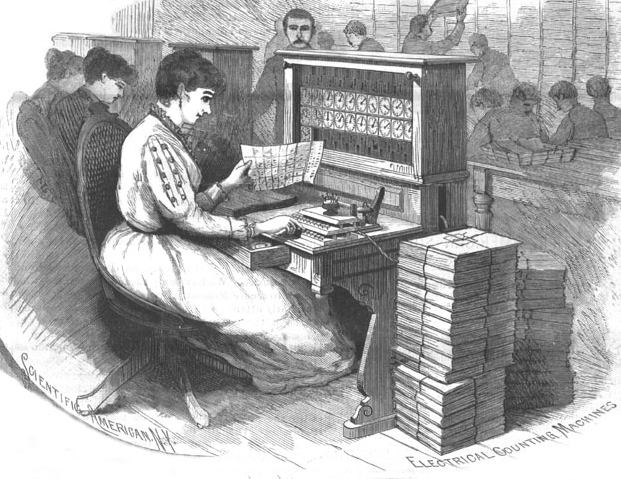

El proyecto Corpus de derecho castellano-indiano / digital es una propuesta colectiva e interdisciplinaria que abarca la compilación, digitalización, procesamiento, macroanálisis y publicación anotada en línea del conjunto de los textos jurídicos vigentes en el marco de la monarquía castellana entre el siglo XIII y principios del XIX. El núcleo principal del proyecto es la construcción de un modelo para el macroanálisis de estos textos jurídicos y, en consecuencia, la generación de herramientas analíticas y de consulta del corpus que permitan comprender la interrelación entre sus distintos elementos semánticos y conceptuales y su transformación a través de los siglos y así proponer una interpretación de cómo es que posiblemente funcionaban en el contexto del discurso y la práctica en el orden jurídico tradicional de la cultura jurisdiccional, tanto en el ámbito de la doctrina, del ejercicio de la potestad normativa como en el del actuar cotidiano del aparato de gobierno e impartición de justicia.

El proyecto implica diversas conexiones y diálogos en distintos ámbitos. En el ámbito interdisciplinario, entre los historiadores de la corriente crítica (cultural) del derecho, lingüistas, humanistas digitales y programadores; en el ámbito teórico y metodológico, entre dos posturas acaso antagónicas en apariencia: la lectura densa y cercana de los textos jurídicos hecha por la historia cultural del derecho a lo largo de varias décadas y la lectura distante. Lo anterior nos obliga a discutir ciertos principios teóricos, como lectura densa, tomada por la historia cultural del derecho de la idea de descripción densa (Geertz, 1973), como sistema capaz de ser leído como texto en relaciones contextuales, o un nivel más complejo (Genette, 1992) y su noción de transtextualidad. Varios historiadores del derecho han aplicado incluso algo parecido a la lectura cercana del criticismo literario (Clavero, 1991). Esto interesa al estudiar el derecho de antiguo régimen frente a la posibilidad de aplicación de metodologías computacionales enfocadas, generalmente, a una lectura distante (Moretti, 2013) en la búsqueda de estructuras formales mediante el análisis de grandes cantidades de texto/data. Es justamente necesario pensar en la posibilidad de ensayar no sólo una minería de texto cuantitativa sino en aspectos más cualitativos, modelando campos semánticos que se transforman históricamente.

Cabe aclarar que el criterio de selección de fuentes para la conformación del corpus es complejo y presenta muchos problemas. Responde a una historiografía que ha definido el campo de lo jurídico en el antiguo régimen hispánico como algo más allá del texto jurídico normativo (entendido como ley). Incluye la doctrina de los juristas y de los teólogos por considerarse que la cultura jurídica tiene una estrecha relación con la doctrina católica. El corpus completo abarcaría tanto normas como doctrina y costumbre y se consideran textos jurídicos producidos tanto en Castilla como en los territorios americanos de la monarquía. Por lo tanto, no se trata de un corpus reunido de antemano en su propia época, sino de un corpus compuesto por el conjunto de la comunidad de historiadores dado que se ha analizado su utilización práctica a lo largo de los siglos y en un contexto cultural determinado (Castilla y sus dominios ultramarinos entre los siglos XIII y XIX). Tener claro cómo suponemos que se definía un texto jurídico en el antiguo régimen es de suma importancia ya que el interés del proyecto es generar una comunidad colaborativa de investigación interdisciplinario que determine sus elementos semánticos necesarios para poder caracterizar digitalmente este tipo de textos. Esto es primordial puesto que son textos completamente distintos de los literarios o de otra índole que se han considerado, por ejemplo, en la iniciativa TEI. Dicho de otra forma, el nodo fundamental del problema es cómo se construye un corpus histórico jurídico particular para que sea útil en las humanidades digitales.

Como la reunión del corpus completo es un proyecto a muy largo plazo, en una etapa piloto consideramos que trabajar con los textos normativos puede ser suficiente para ensayar la propuesta de un modelo flexible y escalable. Además, para el caso de los textos normativos ya existe un ordenamiento y un proceso de digitalización previo de esa parte del corpus. De unas 35,355 normas referenciadas se han puesto en línea, de manera digital básica, 26,831 por un grupo de académicos españoles que viene trabajando al respecto desde la década de 1970 y en el que se han ya recogido la mayor parte de las normas legisladas entre el año 1020 y 1868. Por tanto, el objetivo de esta ponencia es discutir los diferentes ejes de nuestra propuesta teórica: 1) el aspecto de su realidad digital, es decir, cuáles son los requisitos para una digitalización óptima de fuentes jurídicas que se presentan en la realidad de maneras diversas –manuscritas, impresas, cuyos contenidos varían ortográfica y semánticamente a lo largo de los siglos-, 2) el problema de qué se concibe como texto propio de la cultura jurisdiccional en el orden jurídico tradicional –no sólo los obviamente jurídicos en apariencia-, y, en consecuencia, 3) los retos que implica el diseño de herramientas digitales propias que permitan el macroanálisis de los textos como datos masivos. Esto, a su vez, implica un problema mayor y de fondo que es el de la conexión entre un necesario abordaje hermenéutico de los textos jurídicos (lectura densa) en una perspectiva de larga duración –desde la baja edad media hasta el fin de la edad moderna– para entender su contexto cultural de sentido, y el reto de procesar dichos textos entendidos como corpus y en forma de datos masivos mediante computadora (lectura distante), no sólo en procesos de segmentación del corpus para su visualización (nubes de palabras, frecuencias relativas y absolutas, KWIC), sino la posibilidad de ensayar, sobre todo, un modelado tópico semántico con objeto de reflexionar sobre cuál sería un modelo de macroanálisis adecuado para este tipo de corpus. Finalmente, proponer un modelo particular para la edición digital del corpus de los textos jurídicos propios de la cultura jurisdiccional del orden jurídico tradicional.

Referencias

Clavero, B. (1991). Antidora: antropología católica de la economía moderna. Milano: Giuffrè

Geertz, C. (1973). The Interpretation of Cultures: Selected Essays. New York: Basic Books.

Genette, G. (1992). The architext : an introduction. Berkeley: University of California Press.

Moretti, F. (2013). Distant Reading. London: Verso.